Batch Normalization | Abstract 第1文

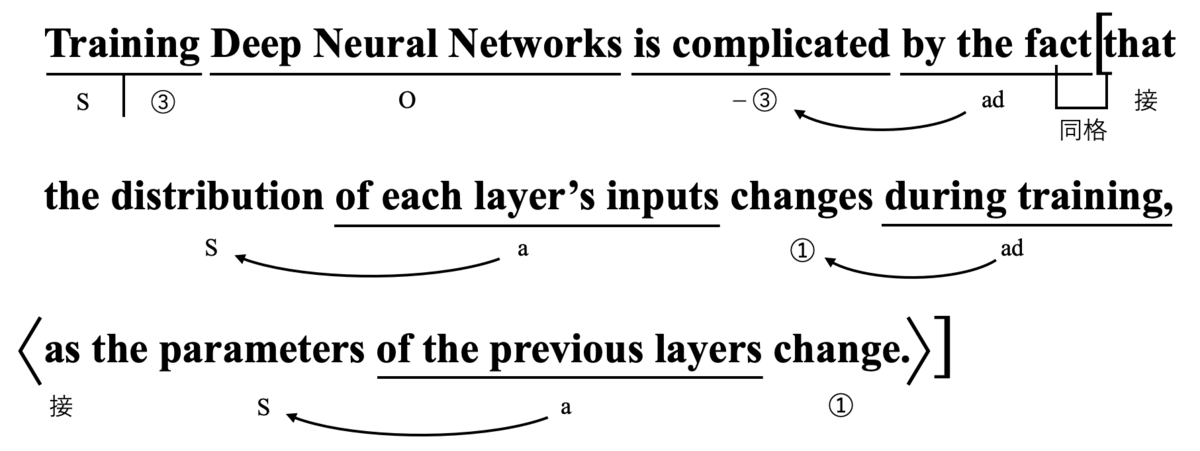

Training Deep Neural Networks is complicated by the fact that the distribution of each layer’s inputs changes during training, as the parameters of the previous layers change.

Sergey Ioffe, et al., "Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift"

内部共変量シフトを抑えることで過学習を抑制するBatch Normalizationの論文であるのFrame of Reference(F.o.R.)を使って英文構造を解読します。

「ディープニューラルネットワーク(DNN)を訓練することは、前の層のパラメーターが変化するにつれて、各層の入力の分布が訓練中に変化するという事実によって、複雑になっている。」

薬袋善郎先生の公式ウェブサイト